Se provaste ad effettuare una ricerca su Google utilizzando come criterio «Second Life» vi ritrovereste con più di 600 milioni di risultati. Questo non è certo un fatto probante, ma dà un’idea dell’interesse che ha suscitato negli ultimi sei mesi l’ambiente tridimensionale della Linden Lab nella rete e soprattutto fuori dalla rete. Il fenomeno Second Life, tuttavia, non è tanto un fenomeno tecnologico quanto un fenomeno sociale e come tale va interpretato. Fatto questo, e solo allora, potremo ragionare sulle implicazioni tecnologiche e sul loro impatto positivo o negativo all’interno della nostra società e sul mercato.

Obiettivo di questo articolo è condividere una serie di considerazioni che, spero, aiuteranno a fare chiarezza su questo fenomeno e a dare una chiave di lettura più oggettiva di qualcosa di cui si parla molto ma ben poco si sa ancora veramente, e questo anche tra gli addetti ai lavori. Prima, però, è necessario introdurre un paio di termini: il primo riguarda il cosiddetto Ciclo di Hype, il secondo il concetto di Metaverso.

Il Ciclo di Hype

Ogni qual volta si introduce una nuova tecnologia all’interno di un sistema sociale, si verificano tutta una serie di reazioni la cui successione può essere ben descritta da una curva detta Ciclo di Hype. In inglese hype indica un lancio pubblicitario sensazionalistico o una montatura giornalistica, in pratica un evento fortemente mediatico che genera un entusiasmo e un’aspettativa esagerate rispetto a un determinato fatto.

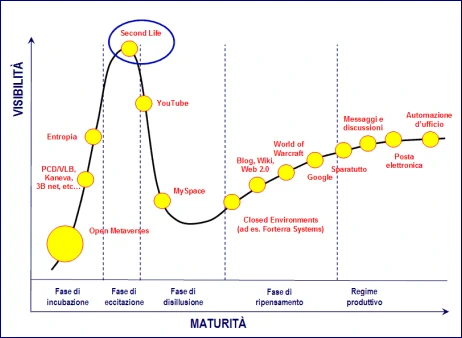

La curva in questione è caratterizzata da un picco iniziale piuttosto deciso seguito da una rapida caduta, a cui fa seguito a sua volta una crescita piuttosto contenuta che tende ad appiattirsi all’infinito o comunque risale con una pendenza più o meno modesta, come si può vedere in figura. L’asse delle ascisse rappresenta il livello di maturità della nuova tecnologia, mentre quello delle ordinate la visibilità e l’attenzione che ha all’interno del sistema sociale nel quale è stata introdotta.

Il posizionamento di alcune tecnologie sulla curva sono il risultato di una mia personale analisi del loro livello di maturità e visibilità e quindi possono non essere condivise da altri analisti. In ogni caso riguardano il livello di penetrazione a livello di singoli cittadini e di mercato finale. In genere le aziende tendono ad essere sfasate di un paio di anni in ritardo rispetto a quest’ultimo.

Il ciclo è caratterizzato da cinque fasi.

- La prima riguarda l’introduzione vera e propria da parte di pochi pionieri della nuova tecnologia. In questa fase la tecnologia in questione è ancora piuttosto primitiva e solo chi ha una certa esperienza ne può vedere il potenziale. Di fatto è compresa da pochi e ha una certa difficoltà a farsi conoscere soprattutto dalla massa, anche perché, a parte le riviste specializzate, viene per lo più ignorata dai media.

- Se si tratta di una tecnologia realmente innovativa, con caratteristiche distintive ben definite, e se riesce a sopravvivere alla prima fase e inizia a prender piede, allora la visibilità inizia ad aumentare in modo esponenziale portando l’interesse dalle riviste specializzate ai media generalisti. Questo passaggio, tuttavia, porta a focalizzare l’attenzione non sulla tecnologia in sé, ma su quelle caratteristiche che la distinguono e che vengono gonfiate in modo spropositato per dare agli articoli un carattere di sensazionalismo. Questa fase si chiama «Hype 2», o fase del sovra-entusiasmo, ed è particolarmente importante perché quanto più è significativa maggiore sarà la lunghezza della quarta fase del ciclo. In pratica in questa fase la curva sale fino a raggiungere un picco dal quale inizierà a precipitare più o meno velocemente.

- È questa la fase più delicata del ciclo, detta anche della disillusione. Di questa fase, come della seconda, i protagonisti sono ancora i media non specialistici. Questi, infatti, sull’onda di una certa delusione indotta dalla sempre maggiore consapevolezza da parte della gente del fatto che le aspettative create nella fase due non sembrano realizzarsi, iniziano a produrre tutta una serie di articoli sempre più negativi sulla tecnologia in questione, fino ad arrivare a una vera e propria campagna denigratoria, quasi a voler punire quella tecnologia per non essersi mostrata all’altezza di aspettative che erano solo nella mente di certi giornalisti e che nessun specialista aveva mai prospettato. Questa fase può arrivare quasi ad uccidere la tecnologia in questione o quantomeno a rimandarne lo sviluppo a lungo termine. Tanto più elevata è stata la quota raggiunta dal picco nella fase due e tanto più ripida la caduta nella tre, infatti, tanto più lunga sarà la ripresa nella penultima fase del ciclo.

- In questa fase i riflettori si sono ormai spenti, lasciando che a occuparsi della tecnologia a livello mediatico siano solo le riviste specializzate. Nel frattempo, tuttavia, mentre il resto del mondo si eccitava oltre il ragionevole per poi relegare la novità fra le mode del passato, gli specialisti avevano avuto modo di lavorare per migliorarne le caratteristiche, superarne i difetti e comprenderne meglio le potenzialità. Iniziano ad apparire i primi utilizzi pratici, le prime applicazioni, in sordina e senza tanto chiasso, grazie a volte agli stessi pionieri che l’avevano sviluppata o molto più spesso ad altri che hanno preso il loro posto, se questi sono scomparsi dalla scena come conseguenza della fase tre. Questa fase può durare parecchio ed è sostanzialmente una fase di ricerca e sviluppo che spesso ridefinisce la tecnologia sia nei termini che nel contenuto. A volte, se la delusione della fase tre è stata molto forte, arriva a ridefinirne anche il nome per evitare di incorrere in una crisi di rigetto da parte dell’opinione pubblica.

- Fase cinque, ovvero della maturità. Ormai la nuova tecnologia non è più tale e ha dato prova di utilità e solidità. Se ne torna a parlare, spesso non più direttamente, ma attraverso le sue applicazioni. La visibilità è più bassa a livello di masse, ma ha conquistato la fiducia del mercato che inizia ad utilizzarla e a riproporla in una veste più fruibile. Da qui in poi si evolverà come tutte le tecnologie alle quali siamo abituati, in cui ogni novità viene rapidamente digerita e assimilata senza troppi traumi.

Qualche esempio pratico

Di esempi del Ciclo di Hype ultimamente ne abbiamo avuti parecchi. Provate a pensare ai telefoni cellulari: all’inizio ebbero difficoltà a essere accettati dal mercato, poi si creò rapidamente sul fenomeno un interesse spropositato, con articoli che già ci vedevano con microtelefoni ovunque, nell’orologio, in un braccialetto, persino sottocutanei. Quindi iniziarono a uscire tutta una serie di articoli negativi sulla tecnologia cellulare: prima si cominciò a parlare di status symbol, tanto che avere un cellulare sembrava quasi un’ostentazione, nonostante già i prezzi fossero calati di molto; poi si arrivò a parlare di presunti danni che le onde elettromagnetiche avrebbero prodotto friggendo letteralmente il cervello dei poveri utilizzatori; infine si parlò, come già per la televisione, il cinema e altre tecnologie di comunicazione, di assuefazione, di impatto psicologico negativo sui giovani e quant’altro. Pian piano, tuttavia, il cellulare ha iniziato a diventare una presenza stabile nella nostra realtà tanto da sostituire di fatto persino il telefono fisso di casa. Oggi, almeno in Italia, abbiamo più di un cellulare a persona e non è raro vedere bambini anche piccolissimi usarlo con la massima naturalezza. In quanto ai potenziali danni, quasi vent’anni di analisi e dati statistici ci confortano ormai sull’innocuità dei telefonini quali possibili responsabili dell’insorgere di tumori al cervello o di produrre altri danni all’organismo. Possiamo quindi dire che i cellulari sono ormai nella fase cinque del ciclo.

Attraverso il Ciclo di Hype è passata anche Internet, ovviamente: prima quasi ignorata — la domanda tipica di questa fase è «Ma a che serve?» — poi osannata in modo spropositato — «Sostituirà la carta stampata, i libri, persino la TV!» — quindi fonte di tutti i mali, dalla pedopornografia ai disturbi psicologici dei più piccoli. Oggi non c’è persona o azienda che non abbia un indirizzo di posta elettronica, così come sono sempre di più quelli che navigano in rete per chiacchierare, cercare informazioni, acquistare prodotti o servizi. La rete è ancora tuttavia nella fase quattro, perché ci sono interi settori che ne fanno un uso limitato, come la Pubblica Amministrazione, e anche le aziende non la sfruttano ancora come potrebbero.

Sempre in fase quattro, appena uscita dalla tre, sono i blog e in generale tutto il mondo Web 2.0. Passato un periodo di entusiasmo, soprattutto durante la Guerra del Golfo, i blog hanno subito una serie di attacchi da parte dei media tradizionali in quanto visti come pericolosi concorrenti. Oggi la maggior parte dei quotidiani ha il suo blog, così come ce l’hanno un numero sempre maggiore di giornalisti. Ogni tanto, tuttavia, qualche stoccata arriva ancora, per cui non possiamo dire di essere del tutto al di fuori della fase tre. Analogamente Wikipedia, che sta iniziando a subire una serie di critiche che, seppure facciano riferimento in parte a fatti inconfutabili, non tolgono nulla all’importanza e al significato di un’iniziativa assolutamente epocale quale quella della creazione di un’enciclopedia globale e multilingue su base assolutamente volontaria. Diciamo quindi che il Web 2.0 è più o meno spalmato fra la fase tre e la cinque, dato che comprende in sé ben più di una singola tecnologia, non tutte allo stesso livello di maturità.

E Second Life? Ci arriviamo, ma prima introduciamo il secondo concetto, quello di metaverso.

Cos’è un Metaverso

Un metaverso è un ambiente immersivo caratterizzato da interazioni sociali più o meno significative e dalla simulazione di un’ambiente più o meno reale. Non è detto che debba essere tridimensionale. Ci sono metaversi a due dimensioni, stile cartone animato, ma la tridimensionalità rappresenta una ghiotta opportunità per molte aziende di hardware, dato che richiede risorse significative, per cui si spinge molto in quella direzione. Ambienti di questo tipo non sono in sé una tecnologia nuova, basti pensare ai giochini che da sempre hanno infestato i nostri computer, a partire dal datato Pong o da Pacman, fino ad arrivare agli sparatutto stile Doom e al buon vecchio simulatore di volo che già girava su macchine la cui potenza, oggi, è superata persino da alcuni cellulari.

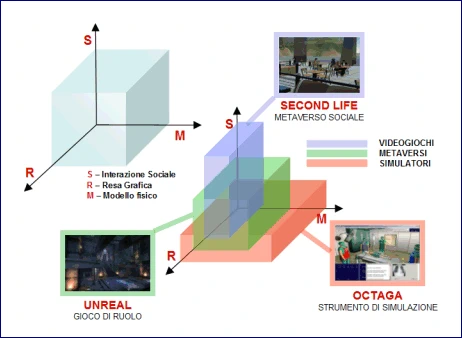

In generale un ambiente virtuale tridimensionale immersivo è caratterizzato da tre fattori:

- La resa grafica, ovvero quanto realistica è la grafica utilizzata in termini di forme, colori, fondali, personaggi e oggetti.

- Il modello fisico, ossia quanto il comportamento dell’ambiente e degli oggetti e dei personaggi all’interno dell’ambiente è realistico in termini di rispetto delle leggi naturali.

- Il sistema sociale, ovvero quanto significative sono le relazioni sociali fra coloro che si trovano nello stesso momento nell’ambiente virtuale e quanto queste sono facilitate se non sollecitate dal sistema.

Gli esempi qui riportati sono solo orientativi. Le misurazioni lungo i vari assi non rappresentano valori precisi ma solo indicazioni di massima di come si posizionano i vari ambienti virtuali 3D rispetto ai parametri di riferimento.

Gli ambienti 3D

Facciamo alcuni esempi. Prendiamo un MMORPG (Massive Multiplayer Online Role-Playing Game), ovvero un gioco di ruolo in rete al quale possono partecipare molti utenti contemporaneamente collegandosi da qualsiasi parte del mondo. Questo genere di ambiente è sempre più caratterizzato da modelli grafici di alta qualità, assolutamente realistici e spesso intesi a rendere molto appetibile il gioco sul piano estetico. Il modello fisico è spesso abbastanza buono, ma dipende dal tipo di gioco. Ad esempio, se si tratta di una corsa automobilistica, le macchine devono potersi comportare apprezzabilmente come una vera macchina da corsa, tanto da poter sbandare e magari capottarsi, ma in genere non si danneggiano come quelle vere in modo da aiutare i principianti a insistere anche dopo le prime uscite di strada e i primi incidenti. Il buon vecchio Flight Simulator, invece, dato che non era un gioco ma un vero e proprio strumento di apprendimento, era molto più severo a riguardo. In altri giochi il modello fisico è rispettato solo fino a un certo punto. Ad esempio, nelle battaglie fra astronavi gli effetti speciali si sprecano, sebbene nel vuoto esplosioni e raggi della morte non farebbero alcun rumore. Ma qui, più che il modello fisico, va rispettato lo standard affermatosi di film come Guerre Stellari e Star Trek. In quanto al modello sociale è sempre abbastanza limitato in questi giochi. Chi gioca lo fa per vincere e, sebbene esistano giochi a squadra, la collaborazione è spesso limitata al minimo necessario per raggiungere l’obiettivo.

Sul lato opposto ci sono i simulatori, ad esempio quelli impiegati nell’apprendimento di tecniche chirurgiche. Anche qui la resa grafica è elevata, dato che ogni elemento deve essere molto preciso, seppure a volte si riduca il realismo proprio per accentuare il feedback visivo, spesso per evidenziare maggiormente la reazione dell’organo a determinate azioni, come l’impallidire del volto o lo spasmo di un muscolo. Sono comunque reazioni regolabili a seconda dell’esperienza dello studente. Il modello fisico invece è curato al massimo, perché è soprattutto quello a rappresentare il terreno di prova dell’apprendista chirurgo. L’interazione sociale, viceversa, è spesso limitata dato che si opera secondo processi e protocolli ben definiti, per cui, seppure si comunica, lo si fa secondo determinate regole e non a ruota libera. Stesso discorso per un simulatore di combattimento fra aerei da caccia o per un sistema di formazione di processi aziendali.

In mezzo ci sono appunto i metaversi, ovvero sistemi come Second Life, fortemente orientati al social networking, dove la grafica è secondaria, seppure non ininfluente, mentre il modello fisico è quasi inesistente, tant’è che si può volare, attraversare i muri, camminare sott’acqua senza affogare. In questi sistemi quello che importa sono le relazioni fra persone, la comunicazione, l’interazione, e quindi sono molto adatti alla formazione remota, alla rappresentazione di eventi live, allo sviluppo di pratiche psicoterapeutiche individuali e soprattutto di gruppo, specialmente in situazioni in cui il filtro visivo può facilitare l’interazione e la comunicazione. In questo genere di sistemi il concetto di virtuale che spesso si associa alla rete diventa sempre più sfumato contribuendo a sfatare il mito che vuole il virtuale contrapposto al reale nel mondo dell’informatica. La rete, infatti, è reale quanto le persone che vi sono dietro e come tale va interpretata, ovvero come un’estensione della realtà con la quale condivide tutte le caratteristiche, buone e cattive. Ma questo è un’altro discorso che prima o poi riprenderemo.

Second Life: verso Hype 3

E siamo giunti così a Second Life. Stiamo parlando di un metaverso quindi, ovvero di un ambiente virtuale immersivo orientato al sociale e all’interazione. Nello specifico, tuttavia, ci troviamo di fronte a una realizzazione basata su un’architettura un po’ datata e non ottimale, sulla quale si è creata una certa bolla speculativa e con forti difficoltà sia dal punto di vista tecnologico che economico. Questo tuttavia non toglie nulla al fatto che si tratti di una delle realizzazioni più interessanti al momento di metaverso tridimensionale a carattere sociale.

Dove si posiziona nel Ciclo di Hype? Sicuramente in cima alla fase due, in bilico verso la discesa che la porterà inesorabilmente in «Hype 3» nei prossimi mesi. Già si iniziano a vedere i primi articoli negativi, le prime critiche feroci, non da parte degli addetti ai lavori, che da tempo cercavano inutilmente di equilibrare la spinta mediatica che ne aveva fatto una vera e propria moda, ma proprio da parte dei media tradizionali, ovvero stampa e canali televisivi.

Cosa succederà, quindi, nei prossimi mesi? Previsioni specifiche è piuttosto difficile farlo, perché molto dipenderà da come Linden Lab si comporterà a fronte dell’ingresso nella fase di disillusione. Che si andrà verso la fase tre è infatti molto probabile se non certo, quanto durerà e che effetti avrà dipende da molti fattori, compresa l’eventuale comparsa sul mercato di alternative più agguerrite, robuste e competitive, come già successe per i primi motori di ricerca, molti dei quali sono ormai scomparsi, con l’arrivo di Google in rete. Che tuttavia i metaversi 3D arriveranno prima o poi a maturità e daranno mostra della loro reale utilità è una previsione possibile e neanche troppo arrischiata. Quali siano i vantaggi di un metaverso, perché possono rappresentare un’utile strumento in molti campi e quali potrebbero essere le effettive realizzazioni sarà materia di ulteriori articoli. Quello che importa adesso è di prepararci alla fase 3 per Second Life e di non lasciarci scoraggiare da essa: il metaverso della Linden è in fondo solo un’implementazione specifica di un nuovo paradigma di comunicazione e un suo eventuale successo o fallimento non rappresenta necessariamente un successo o un fallimento dell’intero paradigma. Chi su queste cose lavora lo sa e sta già lavorando per consolidare un ulteriore mattoncino in quella grande infrastruttura planetaria di comunicazione e collaborazione che è la rete globale. L’importante è mantenere i piedi piantati bene a terra pur avendo la testa "fra le nuvole". In fondo è questo che caratterizza il pioniere: saper essere allo stesso tempo visionari e concreti. Un pioniere che non sia visionario, infatti, non andrà oltre la seconda catena di montagne che gli sbarrano il cammino, quello che non dovesse essere concreto… beh, sarebbe un pioniere morto.

ciao! a parte ringraziarti per la condivisione qui e dovunque, posso domandarti a quali simulatori di tecniche chirurgiche fai riferimento? con tutta la pratica di 3d che hai, perché non torni sull’argomento? magari con qualche suggerimento per lasciarci sperimentare e capire?

Un esempio di simulatore per tecniche chirurgiche è stato realizzato utilizzando Octaga. Un altro esempio è Co-surgeon che prevede anche aspetti di collaborazione in rete.

Altri sistemi utilizzano allo stesso tempo tecniche virtuali e periferiche specifiche, tipo tavolette grafiche o componenti di parti umane artificiali dotate di bisturi digitali o altri strumenti analoghi. Alcune servono per addestramento, altre per guidare remotamente un chirurgo a eseguire operazioni su individui veri quando l’esperto non è ha la possibilità di recarsi sul posto.

Per ora si tratta di prodotti molto specifici o progetti realizzati ad hoc. Non li conosco in dettaglio non essendo un medico. Ad ogni modo i simulatori specialistici esistono da decenni; basti pensare ai simulatori di volo. La differenza, oggi, è che esistono piattaforme per sviluppare mini-simulatori a costi molto bassi. Faccio un esempio: se sono l’Airbus e devo sviluppare un simulatore per un nuovo aeromobile, potrò spenderci anche alcuni milioni di euro e sarà sicuramente un prodotto molto curato, non solo graficamente, ma soprattutto nel modello fisico. Ma se sono un piccolo gruppo di volontari che agiscono all’interno della Protezione Civile e desidero affiancare all’addestramento sul campo anche una serie di addestramenti virtuali intesi a provare alcuni schemi di intervento, protocolli di comunicazione, reazioni agli imprevisti, usare un ambiente virtuale anche primitivo come Second Life, può essere più che sufficiente.

sei stato gentilissimo, ora approfondirò. studiando medicina, dato il tuo esempio di simulazioni, mi aveva incuriosito in automatico proprio questo aspetto del che disponibilità ci sia o si vada acquisendo di simulatori efficaci per piccoli budget. 🙂

per la gran parte del nostro insegnamento curriculare tipo, Second Life – ragionando un attimo oltre il problema (temporaneo?) del limite al numero di utenze – sarebbe già sufficiente così com’è a vicariare l’espletamento de “la frequenza”. ma dei simulatori accessibili e performanti, beh, sarebbero una buona occasione per scompaginare davvero il modo in cui impariamo e aumentare il livello di conoscenza.

naturalmente trattasi di una sfida software e hardware gigante, di per sé stessa e soprattutto perché andrebbe portata avanti da persone competenti e altamente competenti e le più competenti sullo scenario specialistico toccato di caso in caso.

mi torna in mente ora, la lettura – su un sito universitario credo d’oltreoceano – di un articolo in cui si supponeva come “il programming” costituisca la base della nuova alfabetizzazione… imposta 🙂

e onestamente, a pensarci da dentro al mio settore, mi rendo solo adesso conto lucidamente di quanto poco vincente possa essere pensare ancora ad una didattica della scrittura o dell’oralità. quando si fa sempre più evidente come, una volta che sarà “pronta” una didattica “programmata e programmabile” – multimediale e immersiva – avrà senso per sempre meno persone trasmettere informazioni e conoscenza in una maniera sì, efficace, ma per forza di cose troppo meno efficace.

ti chiedo perdono se mi sono dilungata nel tuo spazio. ma spero, per il grande appassionato di 3d e di knowledge management che sei, di aver fornito qualche spunto utile a farti tornare ancora sull’argomento… a beneficio di noi (ancora) niubbi di hardware e software 🙂

Anonima #3 ha detto: «…ti chiedo perdono se mi sono dilungata nel tuo spazio…»

Nessun problema: questo spazio esiste proprio per confrontarci sugli argomenti che volta per volta propongo, per cui sentiti libera pure di approfittarne quanto vuoi.

In quanto al discorso sulla realtà virtuale, penso che questo genere di strumenti saranno usati sempre più frequentemente per aiutare non solo lo studente, ma anche il professionista esperto, ad acquisire sempre più esperienze e competenze in materia. Oggi il livello di specializzazione in ambito chirurgico è tale che un chirurgo esperto, diciamo, di operazioni al ginocchio (scusa se uso un linguaggio improprio, ma come ho detto NON sono un medico), potrebbe non avere abbastanza esperienza per operare agli organi interni di un ferito in caso di emergenza. Un supporto remoto, magari assistito da un chirurgo esperto, che nel contempo mostri cosa deve fare e permetta di farlo prima di aprire davvero il paziente, sarebbe prezioso. Così come sarebbe prezioso aiutare un medico generico isolato da un terremoto ad operare, assistito remotamente, una vittima grave qualora un chirurgo esperto non potesse recarsi sul posto.

Immagina anche un altro caso: trasformare la TAC e gli esami radiologici di una persona che deve essere operata in un modello quasi perfetto della stessa su cui l’equipe medica può provare l’operazione in modo virtuale prima di effettuarla davvero. In pratica, non più operare su un modello generico del corpo umano ma sull’esatta riproduzione di uno specifico individuo che magari ha anomalie che richiedono tecniche specifiche. Dopotutto non siamo tutti uguali, anche internamente.

Tutto ciò è già posibile tecnicamente, ma richiede programmi piuttosto raffinati. Non è qualcosa che si può fare con Second Life. Sia il modello fisico, che quello grafico, devono essere quasi perfetti. Questo richiede molto lavoro e quindi questi prodotti costeranno parecchio ancora per diverso tempo, anche perché non sono prodotti di massa e quindi non possono contare sul fattore di scala per ridurre il prezzo. Certo, con piattaforme 3D più semplici, si posso fare comunque cose interessanti, ma solo a livello di medicina di base.

D’altra parte un’università potrebbero accedere ai fondi europei per lo sviluppo di un progetto informatico di spessore nel campo del 3D, ma questo richiederebbe una visione e una capacità di pensare in grande associata nel contempo ad una notevole concretezza che nel nostro Paese manca.

Un’ultima considerazione: oltre agli strumenti 3D, sarebbe opportuno sviluppore strumenti di ausilio alla diagnostica, ovvero basi di conoscenza in grado di autoapprendere che possano aiutare un medico ad effettuare una diagnosi in base ai sintomi e all’anamnesi del paziente. Strumenti del genere sono già possibili. Ovviamente non si deve pensare all’automazione della diagnosi — l’elemento umano è ancora fondamentale — ma con l’arrivo nel nostro Paese di tanti extracomunitarei, ci saranno sempre più casi di malattie piccole e grandi i cui sintomi sono più o meno sconosciuti ai nostri medici. Qualche tempo fa ho verificato il caso di un medico che non era stato in grado di riconoscere persino i sintomi della malaria, malattia una volta ben nota anche in Italia. Avere un ausilio di questo tipo potrebbe persino fare la differenza fra bloccare o meno un’epidemia in una grande città italiana.

allora, solo un paio di considerazioni da condividere.

la prima è sulla tua ultima considerazione: stavi pensando a un’intelligenza artificiale? 🙂 in realtà, se c’è un ambito medico in cui il contributo dell’informatica e dei nuovi media è tangibile, questo è senz’altro quello della diagnostica. chi è in grado di sfruttare in modo consapevole le potenzialità dei nuovi strumenti, ha facile accesso a basi dati la cui fruizione -caso per caso- semplifica non di poco la mission; e, intanto lo sottolineo, perché già la semplice acquisizione di una buona abitudine di base in questo senso potrebbe impattare straordinariamente sull’efficacia di trattamento.

Con questo voglio dire che, se parliamo di programmistica che incroci segni e sintomi rilevati per fornire tutto un elenco di diagnosi da tenere in conto: senz’altro è e sarà sempre più utile ai medici un po’ più “torzoli” per risparmiare errori (falsi negativi, in realtà) e ai medici un po’ meno “torzoli” per risparmiare tempo. 🙂 …ma, di base: è un’opzione che io metterei, ormai, fuori dal dominio dell'”innovazione”. Diversamente sarebbe per quello cui fai cenno tu, ovviamente se ho capito il punto: macchine capaci di compiere una loro -in parte- autonoma discriminazione dell’informazione disponibile? eeh. 🙂 Non so immaginarlo ancora! Non so immaginare quanto affidabili potrebbero essere strumenti di incrocio e scarto e scelta e etc. similautomatizzati delle evidenze: non tanto per la notevole capacità euristica che implicherebbero; quanto perché -a mio umile avviso, beninteso- se c’è un concetto, in medicina, che va ancora molto ma molto “provato”, ecco, questo è senz’altro quello di “algoritmo”. 🙂 E insomma, tagliandola corta, è difficoltoso scommettere che l’entità programmata potrebbe trovare finezza e vera pulizia di ragionamento logico dove non ne ha ancora trovato l’entità programmante.

quanto a tutto il resto della tua risposta, devo dirti che sei stato illuminante – e lo dico con un riguardo particolare alla prospettiva che, me ne rendo consapevole solo ora, ci saranno per forza sempre più e migliori possibilità di modellare l'”individuo” a partire dagli esami del caso. che tanta ricerca e possibilità siano imbrigliate dentro programmi raffinati e costosissimi, inaccessibili a qualsiasi sperimentazione e alle curiosità… è uno di quei peccati che noi feroci amanti del'”open” perdoneremo sempre e solo con tanta tanta difficoltà!

Un’ultima nota: non ho mai pensato di escludere i medici professionisti dal novero di quelli che devono imparare, e ripetere, e migliorarsi, o via dicendo. 🙂 Anzi, per me va da sé che quello della professione, soprattutto, è il campo in cui saper sfruttare certi mezzi può generare eccellenze! il campo dove al massimo dovremo accogliere la sfida di usare la tecnologia, con tutti i plus -costosi- che comunque porta con sé! Oddio, eh… 🙂 sempre che si sia disposti ad accettare la sfida di essere veri buoni professionisti: che consiste nell’essere veri buonissimi studenti, di questi tempi, non è vero?

valentina

Valentina ha detto: «Con questo voglio dire che, se parliamo di programmistica che incroci segni e sintomi rilevati per fornire tutto un elenco di diagnosi da tenere in conto: senz’altro è e sarà sempre più utile ai medici un po’ più “torzoli” per risparmiare errori (falsi negativi, in realtà) e ai medici un po’ meno “torzoli” per risparmiare tempo. 🙂 …ma, di base: è un’opzione che io metterei, ormai, fuori dal dominio dell'”innovazione”.»

Vero, anche se è tutt’altro che diffusa e soprattutto sono poche le basi di conoscenza che contengono informazioni accurate sulle malattie rare e quelle tipiche di geografie estere. Ma prova a rivisitare il concetto in ottica 2.0: non limitarti al vecchio meccanismo dell’I.A. ma vedilo come un sistema collaborativo che permette anche di complementare la logica euristica del software con la condivisione e la collaborazione in rete dell’intera comunità medica… Ricorda: l’innovazione non è nella tecnologia, ma nel modo in cui la usi, ovvero nella mente delle persone.

Valentina ha detto: «se c’è un concetto, in medicina, che va ancora molto ma molto “provato”, ecco, questo è senz’altro quello di “algoritmo”»

Concordo in pieno. Infatti io pensavo comunque a logica euristica e fuzzy che non dia tuttavia la risposta (il mitico “42”!) ma guidi il medico, in un’interazione continua, verso la soluzione.

Tieni comunque presente che ormai ci si è resi conto che la diagnosi è talmente individuale che oggi si parla addirittuta di farmaci specifici che non si basano solo sulle caratteristiche fisico-chimiche del farmaco ma sull’intera storia che ruota attorno al paziente.

Chiudo il corsivo che Valentina ha dimenticato di chiudere… eh eh eh

Proviamo con <i> visto che <em> non ha funzionato. 🙁